Sunʼiy neyron tarmoqlari: Versiyalar orasidagi farq

RakhimovaD (munozara | hissa) „Artificial neural network“ sahifasi tarjima qilib yaratildi |

(Farq yoʻq)

|

31-May 2022, 09:27 dagi koʻrinishi

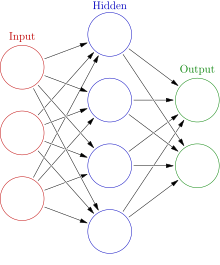

Sun'iy neyron tarmoqlari ( ANN ), odatda oddiygina neyron tarmoqlari ( NN ) deb ataladi, hayvonlar miyasini tashkil etuvchi biologik neyron tarmoqlardan ilhomlangan hisoblash tizimlari.

ANN sun'iy neyronlar deb ataladigan bog'langan birliklar yoki tugunlar to'plamiga asoslanadi, ular biologik miyadagi neyronlarni erkin modellashtiradi. Sun'iy neyron signallarni oladi, keyin ularni qayta ishlaydi va unga ulangan neyronlarga signal berishi mumkin. Ulanishdagi "signal" haqiqiy raqam bo'lib, har bir neyronning chiqishi uning kirishlari yig'indisining chiziqli bo'lmagan funktsiyasi bilan hisoblanadi. Ulanishlar deyiladi qirralar . Neyronlar va chekkalar odatda o'rganish davom etayotganda sozlanadigan vaznga ega. Neyronlar shunday chegaraga ega bo'lishi mumkinki, signal faqat yig'ilgan signal ushbu chegarani kesib o'tgan taqdirdagina yuboriladi. Odatda, neyronlar qatlamlarga yig'iladi. Signallar birinchi qatlamdan (kirish qatlami), oxirgi qatlamga (chiqish qatlami), ehtimol, qatlamlarni bir necha marta bosib o'tgandan keyin o'tadi.

Trening

Neyron tarmoqlar misollarni qayta ishlash orqali o'rganadi (yoki o'qitiladi), ularning har biri ma'lum "kirish" va "natija" ni o'z ichiga oladi va ular o'rtasida ehtimollik bilan o'lchangan assotsiatsiyalarni hosil qiladi, ular tarmoqning o'zida saqlanadigan ma'lumotlar tuzilmasida saqlanadi. Berilgan misol bo'yicha neyron tarmoqni o'rgatish odatda tarmoqning qayta ishlangan chiqishi (ko'pincha bashorat) va maqsadli chiqishi o'rtasidagi farqni aniqlash orqali amalga oshiriladi. Keyin tarmoq o'z vaznli assotsiatsiyalarini o'rganish qoidasiga ko'ra va ushbu xato qiymatidan foydalanib sozlaydi. Ushbu tuzatishlarning etarli sonidan so'ng, mashg'ulot muayyan mezonlar asosida to'xtatilishi mumkin.

Bunday tizimlar misollarni ko'rib chiqish orqali topshiriqlarni bajarishni "o'rganadi", odatda vazifaga xos qoidalar bilan dasturlashtirilmaydi. Masalan, tasvirni aniqlashda ular “mushuk” yoki “mushuk yo‘q” deb qo‘lda yorliqlangan misol tasvirlarni tahlil qilish va boshqa tasvirlardagi mushuklarni aniqlash uchun natijalardan foydalanish orqali mushuklar bor tasvirlarni aniqlashni o‘rganishi mumkin.

Tarix

Uorren Makkallok va Uolter Pits [1] (1943) neyron tarmoqlar uchun hisoblash modelini yaratish orqali mavzuni ochdilar. 1940-yillarning oxirida DO Hebb [2] neyron plastisiya mexanizmiga asoslangan taʼlim gipotezasini yaratdi, u Hebbian oʻrganish nomi bilan mashhur boʻldi. Farley va Uesli A. Klark [3] (1954) Hebbian tarmog'ini simulyatsiya qilish uchun dastlab hisoblash mashinalaridan foydalangan. 1958 yilda psixolog Frenk Rozenblat Amerika Qo'shma Shtatlari Dengiz tadqiqotlari boshqarmasi tomonidan moliyalashtirilgan birinchi sun'iy neyron tarmog'i bo'lgan perseptronni [4] [5] [6] [7] ixtiro qildi. [8] Ko'p qatlamli birinchi funktsional tarmoqlar 1965 yilda Ivaxnenko va Lapa tomonidan Ma'lumotlar bilan ishlashning guruh usuli sifatida nashr etilgan. [9] [10] [11] Uzluksiz orqaga tarqalish asoslari [9] [12] [13] [14] boshqaruv nazariyasi kontekstida 1960 yilda Kelli [15] va 1961 yilda Brayson [16] tomonidan dinamik dasturlash tamoyillaridan foydalangan holda olingan. Keyinchalik tadqiqot Minsky va Papert (1969) dan so'ng to'xtab qoldi, ular asosiy [17] .

1970 yilda Seppo Linnainmaa ichki differensiallanuvchi funktsiyalarning diskret ulangan tarmoqlarini avtomatik farqlashning umumiy usulini (AD) nashr etdi. [18] 1973 yilda Dreyfus boshqaruvchilar parametrlarini xato gradientlariga mutanosib ravishda moslashtirish uchun orqaga tarqalish usulidan foydalangan. [19] 1982 yilda u Linnainmaaning AD usulini neyron tarmoqlarga keng qo'llanilgan usulda qo'lladi. [12] [20]

Bu 1980-yillarda amaliy sun'iy neyron tarmoqlarni ishlab chiqish uchun ko'proq ishlov berish quvvatini ta'minladi. [21]

1986 yilda Rumelhart, Xinton va Uilyams ketma-ketlikda keyingi so'zni bashorat qilishga o'rgatilganda, orqa tarqalish so'zlarning qiziqarli ichki ko'rinishlarini xususiyat vektorlari sifatida o'rganganligini ko'rsatdi. [22]

1988 yildan boshlab, [23] [24] neyron tarmoqlardan foydalanish oqsil tuzilishini bashorat qilish sohasini o'zgartirdi, birinchi kaskadli tarmoqlar bir nechta ketma-ketliklarni tekislash orqali ishlab chiqarilgan profillar (matritsalar) bo'yicha o'qitilganda. [25]

Deformatsiyaga tolerantlik bilan yordam berish uchun max-pooling joriy etildi. [26] [27] [28] Shmidxuber ko'p darajali tarmoqlar ierarxiyasini qabul qildi (1992) nazoratsiz o'rganish orqali bir vaqtning o'zida bir daraja oldindan o'qitilgan va orqaga tarqalish orqali nozik sozlangan. [29]

Neyron tarmoqlarning dastlabki muvaffaqiyatlari birja bozorini bashorat qilish va 1995 yilda (asosan) o'zini o'zi boshqaradigan avtomobilni o'z ichiga oladi. [lower-alpha 1] [30]

Geoffrey Xinton va boshqalar. (2006) har bir qatlamni modellashtirish uchun cheklangan Boltzmann mashinasi [31]. 2012-yilda Ng va Din faqat yorliqsiz tasvirlarni tomosha qilish orqali mushuklar kabi yuqori darajadagi tushunchalarni tan olishni o‘rgangan tarmoq yaratdilar. [32] Nazoratsiz oldindan oʻqitish va GPU va taqsimlangan hisoblash quvvatining ortishi kattaroq tarmoqlardan foydalanishga imkon berdi, xususan, tasvir va vizual aniqlash muammolarida “ chuqur oʻrganish ” nomi bilan mashhur boʻldi. [33]

Ciresan va uning hamkasblari (2010)[34] gradient muammosining yoʻqolishiga qaramay, GPUlar koʻp qatlamli oldinga oʻtiladigan neyron tarmoqlar uchun orqaga tarqalishni amalga oshirish mumkinligini koʻrsatdi. 2009 va 2012 yillar oralig'ida ANN tasvirlarni aniqlash tanlovlarida sovrinlarni qo'lga kirita boshladi, dastlab naqshni aniqlash va qo'l yozuvini tanib olish bo'yicha turli vazifalarda inson darajasidagi ishlashga yaqinlashdi. [35]Masalan, ikki tomonlama va ko'p o'lchovli uzoq qisqa muddatli xotira (LSTM) [36] [37] [38] [39] .2009-yilda o‘rganiladigan uchta til haqida oldindan ma’lumotga ega bo‘lmagan holda qo‘l yozuvini bog‘lash bo‘yicha uchta tanlovda g‘olib chiqdi.[38] [37]

Ciresan va uning hamkasblari yo'l belgilarini tanib olish(IJCNN 2012) kabi mezonlarda insonning raqobatbardosh/g'ayritabiiy ishlashiga [40]erishish uchun birinchi namuna tan oluvchilarni yaratdilar.

Modellar

ANN an'anaviy algoritmlar unchalik muvaffaqiyatli bo'lmagan vazifalarni bajarish uchun inson miyasining arxitekturasidan foydalanishga urinish sifatida boshlandi. Neyronlar bir-biri bilan turli naqshlarda bog'langan, bu ba'zi neyronlarning chiqishi boshqalarning kirishiga aylanishiga imkon beradi. Tarmoq yo'naltirilgan, vaznli grafik hosil qiladi. [41]

Sun'iy neyron tarmog'i simulyatsiya qilingan neyronlar to'plamidan iborat.Har bir neyron boshqa tugunlarga biologik mos keladigan bog'lanishlar orqali bog'langan tugundir.Har bir bo'g'inning vazni bor, bu bir tugunning boshqasiga ta'sir kuchini belgilaydi. [42]

Sun'iy neyronlar

ANN kontseptual ravishda biologik neyronlardan olingan sun'iy neyronlardan iborat. Har bir sun'iy neyron kirishga ega va bir nechta boshqa neyronlarga yuborilishi mumkin bo'lgan bitta chiqishni ishlab chiqaradi. [43]Kirishlar tasvirlar yoki hujjatlar kabi tashqi ma'lumotlar namunasining xususiyat qiymatlari bo'lishi mumkin yoki ular boshqa neyronlarning chiqishi bo'lishi mumkin.

Neyronning chiqishini topish uchun, avvalo, kirishlardan neyronga bo'lgan ulanishlar og'irligi bilan o'lchangan barcha kirishlarning vaznli yig'indisini olishimiz kerak. Biz bu summaga noaniq atama qo'shamiz. [44] Ushbu vaznli summa ba'zan faollashtirish deb ataladi.Dastlabki ma'lumotlar tasvirlar va hujjatlar kabi tashqi ma'lumotlardir. Yakuniy natijalar tasvirdagi ob'ektni tanib olish kabi vazifani bajaradi. [45]

Tashkilot

Neyronlar odatda bir nechta qatlamlarga, ayniqsa chuqur o'rganishda tashkil etilgan.Neyronlari faqat oldingi va keyingi qatlamlarning neyronlari bilan bog'lanadi. Yakuniy natijani beradigan qatlam chiqish qatlamidir .Ular birlashma bo'lishi mumkin, bu erda bir qatlamdagi neyronlar guruhi keyingi qatlamdagi bitta neyronga ulanadi va shu bilan bu qatlamdagi neyronlar sonini kamaytiradi. [46] Faqatgina shunday ulanishga ega bo'lgan neyronlar yo'naltirilgan asiklik grafikni hosil qiladi va <i id="mw_Q">oldinga besleme tarmoqlari</i> sifatida tanilgan. [47] Shu bilan bir qatorda, bir xil yoki oldingi qatlamlardagi neyronlar o'rtasida ulanishga imkon beruvchi <i id="mwAQE">tarmoqlar takroriy tarmoqlar</i> deb nomlanadi . [48]

Giperparametr

Giperparametr doimiy parametr bo'lib, uning qiymati o'quv jarayoni boshlanishidan oldin o'rnatiladi. Parametrlarning qiymatlari o'rganish orqali olinadi. Giperparametrlarga o'rganish tezligi, yashirin qatlamlar soni va partiya hajmi kiradi. [49] Ba'zi giperparametrlarning qiymatlari boshqa giperparametrlarnikiga bog'liq bo'lishi mumkin.

O'rganish

O'rganish - bu namunaviy kuzatishlarni hisobga olgan holda vazifani yaxshiroq hal qilish uchun tarmoqni moslashtirish. O'rganish natijaning aniqligini oshirish uchun tarmoqning og'irliklarini (va ixtiyoriy chegaralarni) sozlashni o'z ichiga oladi. Qo'shimcha kuzatishlarni o'rganayotganda o'rganish tugallangan bo'lib, xatolik darajasini kamaytirmaydi. Agar o'rganganingizdan so'ng, xato darajasi juda yuqori bo'lsa, tarmoq odatda qayta ishlab chiqilishi kerak. Amalda bu o'rganish davomida davriy ravishda baholanadigan xarajat funksiyasini aniqlash orqali amalga oshiriladi. Xarajat ko'pincha statistik ma'lumot sifatida aniqlanadi, uning qiymati faqat taxminiy baholanishi mumkin. Chiqishlar aslida raqamlardir, shuning uchun xatolik past bo'lsa, chiqish (deyarli mushuk) va to'g'ri javob (mushuk) o'rtasidagi farq kichik bo'ladi. Ko'pgina o'rganish modellarini optimallashtirish nazariyasi va statistik baholashning to'g'ridan-to'g'ri qo'llanilishi sifatida ko'rish mumkin. [50] [41]

O'rganish darajasi

O'rganish tezligi modelning har bir kuzatishdagi xatolarni tuzatish uchun ko'rsatadigan tuzatish qadamlari hajmini belgilaydi. [51] Yuqori o'rganish tezligi mashg'ulot vaqtini qisqartiradi, ammo past aniqlik bilan, pastroq o'rganish ko'proq vaqt talab etadi, lekin aniqroq bo'lishi mumkin. Quickprop kabi optimallashtirishlar, birinchi navbatda, xatolarni minimallashtirishni tezlashtirishga qaratilgan bo'lsa, boshqa yaxshilanishlar asosan ishonchlilikni oshirishga harakat qiladi. Tarmoq ichidagi tebranishlarni, masalan, ulanish og'irliklarining o'zgarishini oldini olish va konvergentsiya tezligini yaxshilash uchun takomillashtirish moslashtirilgan o'rganish tezligidan foydalanadi, bu mos ravishda oshiradi yoki kamayadi. [52] 0 ga yaqin momentum gradientni ta'kidlaydi, 1 ga yaqin qiymat esa oxirgi o'zgarishlarni ta'kidlaydi.

Narx funksiyasi

Xarajat funktsiyasini ad hoc aniqlash mumkin bo'lsa-da, ko'pincha tanlov funktsiyaning kerakli xususiyatlari (masalan, qavariqlik ) yoki modeldan kelib chiqqanligi sababli aniqlanadi (ehtimollik modelida modelning orqa ehtimoli teskari sifatida ishlatilishi mumkin).

Orqaga tarqalish

Orqa tarqalish - bu o'rganish jarayonida aniqlangan har bir xatoni qoplash uchun ulanish og'irliklarini sozlash uchun ishlatiladigan usul. Og'irlikni yangilash stokastik gradient tushishi yoki boshqa usullar orqali amalga oshirilishi mumkin, masalan, Extreme Learning Machines, [53] "No-prop" tarmoqlari, [54] orqaga yo'l qo'ymasdan mashq qilish, [55] "vaznsiz" tarmoqlar, [56] [57] ] [57] va konnektsionist bo'lmagan neyron tarmoqlar .

Paradigmalarni o'rganish

Uchta asosiy ta'lim paradigmalari nazorat ostida o'rganish, nazoratsiz o'rganish va mustahkamlovchi o'rganishdir . Ularning har biri ma'lum bir o'quv vazifasiga mos keladi

Nazorat ostida o'rganish

Nazorat ostidagi o'rganish juftlashtirilgan kirishlar va kerakli natijalar to'plamidan foydalanadi..Bu holda xarajat funktsiyasi noto'g'ri ajratmalarni bartaraf etish bilan bog'liq. [58] Keng tarqalgan ishlatiladigan xarajat o'rtacha kvadrat xato bo'lib, u tarmoqning chiqishi va kerakli natija o'rtasidagi o'rtacha kvadrat xatoni minimallashtirishga harakat qiladi. Nazorat ostida o'rganish uchun mos bo'lgan vazifalar naqshni aniqlash (klassifikatsiya deb ham ataladi) va regressiya (funktsiyani yaqinlashish deb ham ataladi) hisoblanadi. Nazorat ostida o'rganish ketma-ket ma'lumotlarga ham tegishli (masalan, qo'lda yozish, nutq va imo- ishoralarni aniqlash uchun).

Nazoratsiz o'rganish

Xarajatlar funktsiyasi vazifaga (model sohasi) va har qanday apriori taxminlarga (modelning yashirin xususiyatlari, uning parametrlari va kuzatilgan o'zgaruvchilar) bog'liq. Arzimas misol sifatida modelni ko'rib chiqing qayerda doimiy va xarajat hisoblanadi . Xarajat funktsiyasi ancha murakkab bo'lishi mumkin. Uning shakli qo'llanilishiga bog'liq: masalan, siqishda u o'rtasidagi o'zaro ma'lumot bilan bog'liq bo'lishi mumkin va , holbuki, statistik modellashtirishda bu ma'lumotlar berilgan modelning posterior ehtimoli bilan bog'liq bo'lishi mumkin (esda tutingki, bu ikkala misolda ham bu miqdorlar minimallashtirilgan emas, balki maksimallashtiriladi).

O'rganishni mustahkamlash

Video o'yinlarni o'ynash kabi ilovalarda aktyor bir qator harakatlarni amalga oshiradi va har biridan keyin atrof-muhitdan umuman oldindan aytib bo'lmaydigan javob oladi. O'qitishni mustahkamlashda maqsad uzoq muddatli (kutilgan yig'ilgan) xarajatlarni minimallashtiradigan harakatlarni amalga oshirish uchun tarmoqni tortish (siyosatni ishlab chiqish) hisoblanadi. Vaqtning har bir nuqtasida agent biror harakatni amalga oshiradi va atrof-muhit ba'zi (odatda noma'lum) qoidalarga ko'ra kuzatuv va bir lahzalik xarajatlarni keltirib chiqaradi. Har qanday vaziyatda agent xarajatlarni aniqlash uchun yangi harakatlarni o'rganish yoki tezroq davom etish uchun oldingi o'rganishdan foydalanishga qaror qiladi.

Rasmiy ravishda atrof-muhit davlatlar bilan Markov qaror jarayoni (MDP) sifatida modellashtirilgan va harakatlar . Holatga o'tishlar noma'lum bo'lgani uchun uning o'rniga ehtimollik taqsimotlari qo'llaniladi: lahzali xarajatlar taqsimoti , kuzatish taqsimoti va o'tish taqsimoti , siyosat esa kuzatishlar berilgan harakatlar bo'yicha shartli taqsimlash sifatida belgilanadi.

ANN bunday ilovalarda o'rganish komponenti bo'lib xizmat qiladi. [59] [60] ANN bilan birgalikda dinamik dasturlash (neyrodinamik dasturlash) [61] ANN qobiliyati tufayli transport vositalarini marshrutlash, [62] video o'yinlar, tabiiy resurslarni boshqarish [63] [64] va tibbiyot [65] kabi muammolarga qo'llanilgan. nazorat masalalarini echish uchun sonli yaqinlashish uchun diskretizatsiya tarmog'ining zichligini kamaytirishda ham aniqlik yo'qotilishini kamaytirish.

O'z-o'zini o'rganish

Neyron tarmoqlarda o'z-o'zini o'rganish 1982 yilda Crossbar Adaptive Array (CAA) deb nomlangan o'z-o'zini o'rganishga qodir neyron tarmog'i bilan birga kiritilgan. [66] Bu faqat bitta kirish, vaziyat s va faqat bitta chiqish, harakat (yoki xatti-harakatlar) bo'lgan tizimdir. Unda na tashqi maslahat kiritish, na atrof-muhitdan tashqi mustahkamlash kiritish mavjud. Tizim idrok va hissiyot o'rtasidagi o'zaro ta'sir orqali boshqariladi. [67] Xotira matritsasi W =||w(a,s)|| ni hisobga olgan holda, har bir iteratsiyada o'zaro bog'liqlikni o'z-o'zidan o'rganish algoritmi quyidagi hisoblashni amalga oshiradi:

Vaziyatda a harakatini bajaring; Natijali vaziyatni qabul qilish s'; Oqibat holatida bo'lish hissiyotini hisoblash v(lar'); O'zaro faoliyat xotirani yangilang w'(a,s) = w(a,s) + v(s').

CAA ikkita muhitda mavjud bo'lib, biri o'zini tutadigan xulq-atvor muhiti va ikkinchisi genetik muhit bo'lib, u erdan dastlab va faqat bir marta xulq-atvor muhitida duch keladigan vaziyatlar haqida dastlabki his-tuyg'ularni oladi. Genetik muhitdan genom vektorini (turlar vektorini) olgandan so'ng, CAA kerakli va nomaqbul vaziyatlarni o'z ichiga olgan xulq-atvor muhitida maqsadga intiladigan xatti-harakatni o'rganadi. [68]

Neyroevolyutsiya

Neyroevolyutsiya evolyutsion hisoblash yordamida neyron tarmoq topologiyalari va og'irliklarini yaratishi mumkin. Neyroevolyutsiyaning afzalliklaridan biri shundaki, u "o'lik nuqtalar" ga tushib qolishga kamroq moyil bo'lishi mumkin. [69]

Stokastik neyron tarmog'i

Sherrington-Kirkpatrik modellaridan kelib chiqqan stoxastik neyron tarmoqlar tarmoqqa tasodifiy oʻzgarishlar kiritish yoki tarmoqning sunʼiy neyronlariga stokastik uzatish funksiyalarini, berish yoki ularga stokastik ogʻirliklar berish orqali qurilgan sunʼiy neyron tarmoq turidir.Bu ularni optimallashtirish muammolari uchun foydali vositalarga aylantiradi, chunki tasodifiy tebranishlar tarmoqni mahalliy minimaldan qochishga yordam beradi. [70]

Boshqa

Evolyutsion usullar, [71] gen ifodasini dasturlash, [72] simulyatsiya qilingan tavlanish, [73] kutish-maksimizatsiya, parametrik bo'lmagan usullar va zarrachalar to'dasini optimallashtirish [74] boshqa o'rganish algoritmlaridir. Konvergent rekursiya - serebellar model artikulyatsiya boshqaruvchisi (CMAC) neyron tarmoqlarini o'rganish algoritmi. [75] [76]

Tartiblar

O'rganishning ikkita usuli mavjud: stokastik va ommaviy. Stokastik o'rganishda har bir kiritish vaznni sozlashni yaratadi. To'plamda o'rganish og'irliklari partiya bo'yicha xatolar to'planib, kirishlar partiyasi asosida o'rnatiladi. Biroq, to'plamli o'rganish odatda mahalliy minimal darajaga tezroq va barqaror pasayish imkonini beradi, chunki har bir yangilash partiyaning o'rtacha xatosi yo'nalishi bo'yicha amalga oshiriladi. Umumiy kelishuv "mini-partiyalar" dan, har bir partiyadagi namunalar bilan butun ma'lumotlar to'plamidan stokastik tarzda tanlangan kichik partiyalardan foydalanishdir.

Turlari

ANN ko'plab sohalarda eng ilg'or texnologiyalarning keng oilasiga aylandi. Eng oddiy turlar bir yoki bir nechta statik komponentlarga ega. Jumladan birliklar soni, qatlamlar soni, birlik og'irliklari va topologiya.Dinamik turlar ulardan bir yoki bir nechtasini o'rganish orqali rivojlanishiga imkon beradi. Ikkinchisi ancha murakkab, ammo o'rganish muddatlarini qisqartirishi va yaxshi natijalar berishi mumkin. Ba'zi turlari faqat apparatda ishlaydi, boshqalari esa sof dasturiy ta'minot bo'lib, umumiy maqsadli kompyuterlarda ishlaydi.

Ba'zi asosiy yutuqlarga quyidagilar kiradi: vizual va boshqa ikki o'lchovli ma'lumotlarni qayta ishlashda ayniqsa muvaffaqiyatli bo'lgan konvolyutsion neyron tarmoqlari. [77] [78]Qisqa muddatli uzoq muddatli xotira yoʻqolib borayotgan gradient muammosidan qochadi [79]va katta lugʻatli nutqni aniqlashga yordam beruvchi past va yuqori chastotali komponentlar aralashmasiga ega boʻlgan signallarni boshqara oladi,[80] [81] matndan to- nutq sintezi, [82] [12] [83]va foto-real gaplashuvchi boshlar.[84] Raqobatbardosh tarmoqlar, masalan, bir nechta tarmoqlar (turli xil tuzilishdagi) oʻyinda gʻalaba qozonish [85]yoki kiritilgan maʼlumotlarning haqiqiyligi haqida raqibni aldash kabi vazifalarda bir-biri bilan raqobatlashadigan generativ raqib tarmoqlari . [86]

Tarmoq dizayni

Neyron arxitektura qidiruvi (NAS) ANN dizaynini avtomatlashtirish uchun mashinani o'rganishdan foydalanadi. Asosiy qidiruv algoritmi nomzod modelini taklif qilish, uni ma'lumotlar to'plamiga nisbatan baholash va natijalardan NAS tarmog'ini o'rgatish uchun fikr-mulohaza sifatida foydalanishdir. [87] Mavjud tizimlar orasida AutoML va AutoKeras mavjud. [88]

Dizayn masalalari tarmoq qatlamlarining soni, turi va ulanishini, shuningdek, har birining o'lchamini va ulanish turini (to'liq, birlashma, . . . ).

Giperparametrlar, shuningdek,dizaynning bir qismi sifatida aniqlanishi kerak(ular o'rganilmagan),har bir qatlamda qancha neyron borligi,o'rganish tezligi, qadam, qadam,chuqurlik, qabul qiluvchi maydon va to'ldirish (CNN uchun) va hokazo.

Foydalanish

Sun'iy neyron tarmoqlardan foydalanish ularning xususiyatlarini tushunishni talab qiladi.

- Modelni tanlash: Bu ma'lumotlar taqdimoti va ilovaga bog'liq. Haddan tashqari murakkab modellar sekin o'rganishdir.

- O'rganish algoritmi: O'rganish algoritmlari o'rtasida ko'plab kelishuvlar mavjud. Deyarli har qanday algoritm ma'lum bir ma'lumotlar to'plamini o'qitish uchun to'g'ri giperparametrlar bilan yaxshi ishlaydi. Biroq, ko'rinmas ma'lumotlar bo'yicha trening algoritmini tanlash va sozlash muhim tajribani talab qiladi.

- Barqarorlik: Agar model, xarajat funktsiyasi va o'rganish algoritmi to'g'ri tanlangan bo'lsa, natijada ANN mustahkam bo'lishi mumkin.

ANN imkoniyatlari quyidagi keng toifalarga kiradi:

- Funktsiyani yaqinlashtirish yoki regressiya tahlili, jumladan, vaqt seriyasini bashorat qilish, fitnesga yaqinlashtirish va modellashtirish.

- Tasniflash, shu jumladan naqsh va ketma-ketlikni aniqlash, yangilikni aniqlash va ketma-ket qaror qabul qilish. [89]

- Ma'lumotlarni qayta ishlash, jumladan, filtrlash, klasterlash, ko'r manbalarni ajratish va siqish.

- Robototexnika, shu jumladan boshqarish manipulyatorlari va protezlari .

Ilovalar

Qo'llash sohalariga tizimni identifikatsiyalash va boshqarish (avtomobilni boshqarish, traektoriyani bashorat qilish,[90] jarayonni boshqarish,tabiiy resurslarni boshqarish ), kvant kimyosi, [91]umumiy o'yin o'ynash, [92]naqshni aniqlash (radar tizimlari, yuzni identifikatsiyalash, signal tasnifi, [93]3D rekonstruksiya, [94]obyektni aniqlash va boshqalar), sensor maʼlumotlarini tahlil qilish, [95]ketma-ketlikni aniqlash (imo-ishora, nutq, qoʻlda yozilgan va bosilgan matnni aniqlash [96] ), tibbiy diagnostika, moliya [97](masalan, avtomatlashtirilgan savdo tizimlari ),ma'lumotlarni qidirish,vizualizatsiya, mashina tarjimasi,ijtimoiy tarmoqlarni filtrlash va elektron pochta spamlarini filtrlash.ANNlar bir nechta saraton turlarini tashxislash uchun. [98] [99]Faqat hujayra shakli haqidagi ma'lumotlardan foydalangan holda yuqori invaziv saraton hujayralarini kamroq invaziv chiziqlardan ajratish uchun ishlatilgan.[100] [101]

ANN tabiiy ofatlarga duchor bo'lgan infratuzilmalarning ishonchliligini tahlil qilishni tezlashtirish uchun [102] [103] va poydevor qo'yishlarini bashorat qilish uchun ishlatilgan. [104]ANN geofanda qora quti modellarini yaratish uchun ham ishlatilgan: gidrologiya,[105] [106]okeanlarni modellashtirish va qirg'oq muhandisligi, [107] [108]va geomorfologiya . [109] ANNlar kiberxavfsizlikda qonuniy faoliyat va zararli harakatlar o'rtasidagi farqni aniqlash maqsadida ishlatilgan. Masalan, mashinani oʻrganish Android zararli dasturlarini tasniflash, [110]tahdid qiluvchi shaxslarga tegishli domenlarni aniqlash va xavfsizlikka xavf tugʻdiruvchi URL manzillarni aniqlash uchun ishlatilgan. [111] Penetratsion testlar, botnetlar, [112] kredit kartalari boʻyicha firibgarlik [113] .

ANN fizikada qisman differensial tenglamalarni yechish va ko'p jismli ochiq kvant tizimlarining xususiyatlarini simulyatsiya [114] uchun vosita sifatida [115] [116] . [117] [118] [119] [120] Miya tadqiqotida ANNlar individual neyronlarning qisqa muddatli xatti-harakatlarini o'rgandilar, [121] neyron zanjirining dinamikasi individual neyronlar o'rtasidagi o'zaro ta'sirlardan va xatti-harakatlarning to'liq quyi tizimlarni ifodalovchi mavhum neyron modullaridan qanday kelib chiqishi mumkinligidan kelib chiqadi.

Nazariy xususiyatlar

Hisoblash kuchi

Ko'p qatlamli perseptron universal yaqinlashish teoremasi bilan tasdiqlangan universal funksiya yaqinlashtiruvchisi hisoblanadi. Biroq, talab qilinadigan neyronlar soni, tarmoq topologiyasi, og'irliklar va o'rganish parametrlari bo'yicha isbot konstruktiv emas.

Ratsional qiymatli og'irliklarga ega o'ziga xos takrorlanuvchi arxitektura (to'liq aniqlikdagi haqiqiy sonli og'irliklardan farqli o'laroq). Cheklangan miqdordagi neyronlar va standart chiziqli ulanishlardan foydalangan holda universal Tyuring mashinasining kuchiga ega [122] . Bundan tashqari, og'irliklar uchun irratsional qiymatlardan foydalanish super-Tyuring kuchiga ega bo'lgan mashinaga olib keladi. [123]

Imkoniyat

Modelning “imkoniyat” xususiyati uning har qanday berilgan funksiyani modellashtirish qobiliyatiga mos keladi. Axborot sig'imi va VC o'lchami. Perseptronning axborot sig'imi ser Devid Makkeyning Tomas Kover ishini jamlagan kitobida [124] qizg'in muhokama qilinadi. [125] Standart neyronlar tarmog'ining sig'imi (konvolyutsion emas) neyronni elektr elementi sifatida tushunishdan kelib chiqadigan to'rtta qoida [126] bilan olinishi mumkin. Axborot sig'imi kirish sifatida har qanday ma'lumot berilgan tarmoq tomonidan modellanadigan funktsiyalarni qamrab oladi. Ikkinchi tushuncha - VC o'lchami . VC Dimension o'lchov nazariyasi tamoyillaridan foydalanadi va eng yaxshi sharoitlarda maksimal quvvatni topadi. Bu ma'lum bir shaklda kiritilgan ma'lumotlardir. [124] da taʼkidlanganidek, ixtiyoriy kiritishlar uchun VC oʻlchami Perceptronning axborot sigʻimining yarmini tashkil qiladi. Ixtiyoriy nuqtalar uchun VC o'lchami ba'zan Xotira hajmi deb ataladi. [127]

Konvergentsiya

Modellar doimiy ravishda bitta yechimga yaqinlashmasligi mumkin, birinchidan, xarajat funktsiyasi va modelga qarab mahalliy minimallar mavjud bo'lishi mumkin. Ikkinchidan, qo'llaniladigan optimallashtirish usuli har qanday mahalliy minimumdan uzoqda boshlanganda birlashishni kafolatlamasligi mumkin.

Yana bir ta'kidlab o'tish kerak bo'lgan masala shundaki, mashg'ulot birlashmani noto'g'ri yo'nalishga olib kelishi mumkin bo'lgan Egar nuqtasini kesib o'tishi mumkin.

Tarmoqning kengligi cheksizlikka yaqinlashganda, ANN o'zining birinchi tartibidagi Teylorning trening davomida kengayishi bilan yaxshi tavsiflanadi va shuning uchun affin modellarning konvergentsiya xatti-harakatlarini meros qilib oladi. [128] [129] Yana bir misol, parametrlar kichik bo'lsa, ANN ko'pincha pastdan yuqori chastotalarga qadar maqsadli funktsiyalarga mos kelishi kuzatiladi. Ushbu xatti-harakatlar neyron tarmoqlarning spektral moyilligi yoki chastota printsipi deb ataladi. [130] [131] [132] [133] Bu hodisa Yakobi usuli kabi ba'zi yaxshi o'rganilgan iterativ raqamli sxemalarning xatti-harakatlariga qarama-qarshidir. Chuqurroq neyron tarmoqlar past chastotali funktsiyalarga nisbatan ko'proq moyil bo'lishi kuzatilgan. [134]

Umumlashtirish va statistika

Maqsadlari ko'rinmas misollarni yaxshi umumlashtiradigan tizim yaratish bo'lgan ilovalar ortiqcha o'qitish imkoniyatiga duch kelishadi. Ikkita yondashuv ortiqcha mashg'ulotlarni hal qiladi. Birinchisi, ortiqcha treninglar mavjudligini tekshirish va umumlashtirish xatosini minimallashtirish uchun giperparametrlarni tanlash uchun o'zaro tekshirish va shunga o'xshash usullarni qo'llashdir.

Bu kontseptsiya probabilistik (Bayesian) doirada paydo bo'ladi, bu erda tartibga solish oddiyroq modellarga nisbatan kattaroq oldingi ehtimollikni tanlash orqali amalga oshirilishi mumkin.Bundan tashqari, statistik o'rganish nazariyasida, maqsad ikkitadan ortiq miqdorni minimallashtirishdan iborat: "ampirik risk" va "tarkibiy xavf", bu taxminan o'quv majmuasi ustidagi xatoga va ko'rinmas ma'lumotlarning haddan tashqari moslashuvi tufayli taxmin qilingan xatoga mos keladi.

O'rtacha kvadrat xatolik (MSE) xarajat funktsiyasidan foydalanadigan nazorat qilinadigan neyron tarmoqlari o'qitilgan modelning ishonchliligini aniqlash uchun rasmiy statistik usullardan foydalanishi mumkin. Tasdiqlash to'plamidagi MSE farqni baholash sifatida ishlatilishi mumkin. Shu tarzda o'tkazilgan ishonch tahlili, agar chiqish ehtimoli taqsimoti bir xil bo'lsa va tarmoq o'zgartirilmasa, statistik jihatdan haqiqiy hisoblanadi.

Kategorik maqsadli o'zgaruvchilar uchun neyron tarmog'ining chiqish qatlamiga (yoki komponentlarga asoslangan tarmoqdagi softmax komponentiga) softmax faollashtirish funksiyasini, logistik funktsiyani umumlashtirishni belgilash orqali natijalarni posterior ehtimolliklar sifatida talqin qilish mumkin. Bu tasniflashda foydalidir, chunki u tasniflashda aniqlik o'lchovini beradi.

Softmax faollashtirish funksiyasi:

Tanqid

Trening

Neyron tarmoqlarning, xususan, robototexnika sohasidagi keng tarqalgan tanqidi shundaki, ular haqiqiy hayotda ishlash uchun juda ko'p tayyorgarlikni talab qiladi. Potensial yechimlar misol boʻyicha tarmoq ulanishlarini oʻzgartirishda unchalik katta qadamlar qoʻymaydigan raqamli optimallashtirish algoritmidan foydalangan holda tasodifiy aralashtirib yuboriladigan oʻquv misollarini oʻz ichiga oladi, misollarni mini-toʻplamlar deb ataluvchi guruhlarda guruhlash va/yoki rekursiv eng kamini kiritish. CMAC uchun kvadratlar algoritmi. [75]

Nazariya

Asosiy e'tiroz shundaki, ANN neyronal funktsiyani etarli darajada aks ettirmaydi. Biologik neyron tarmoqlarda bunday mexanizm mavjud bo'lmasa-da, orqaga tarqalish juda muhim qadamdir. [135] Haqiqiy neyronlar tomonidan ma'lumot qanday kodlanganligi noma'lum. Sensor neyronlari sensor faollashishi bilan harakat potentsiallarini tez-tez yondiradi va ular bilan bog'langan motor neyronlari harakat potentsiallarini tez-tez qabul qilganda mushak hujayralari kuchliroq tortiladi. [136]

ANNning asosiy da'vosi shundaki, ular axborotni qayta ishlashning yangi va kuchli umumiy tamoyillarini o'z ichiga oladi. Bu tamoyillar noto'g'ri ta'riflangan. Ko'pincha ular tarmoqning o'zidan paydo bo'lgan deb da'vo qilinadi.1997 yilda Aleksandr Dyudnining ta'kidlashicha, natijada sun'iy neyron tarmoqlari "hech narsaning o'rniga" sifatga ega bo'lib, u o'ziga xos dangasalik aurasini va bu hisoblash tizimlari qanchalik yaxshi ekanligiga qiziquvchanlikning yo'qligini beradi. Yechimlar xuddi sehr bilan topiladi; va hech kim hech narsani o'rganmaganga o'xshaydi" [137] Dyudniga javoblardan biri shundaki, neyron tarmoqlar koʻplab murakkab va xilma-xil vazifalarni bajaradi: avtonom uchuvchi samolyot [138] dan kredit kartalaridagi firibgarlikni aniqlashgacha, Go oʻyinini oʻzlashtirishgacha.

Texnologiya yozuvchisi Rojer Bridgman shunday dedi:

Biologik miyalar miya anatomiyasi tomonidan xabar qilinganidek, sayoz va chuqur zanjirlardan foydalanadi [139], turli xil o'zgarmaslikni namoyish etadi. Weng [140] miya o'z-o'zidan simlarni asosan signal statistikasiga ko'ra bog'laydi va shuning uchun ketma-ket kaskad barcha asosiy statistik bog'liqliklarni ushlay olmaydi.

Uskuna

Katta va samarali neyron tarmoqlar katta hisoblash resurslarini talab qiladi. [141] Miya neyronlar grafigi orqali signallarni qayta ishlash vazifasiga moslashtirilgan apparatga ega bo'lsa-da, hatto fon Neyman arxitekturasida soddalashtirilgan neyronni taqlid qilish ham katta hajmdagi xotira va xotirani iste'mol qilishi mumkin. Bundan tashqari, dizayner ko'pincha signallarni ushbu ulanishlar va ular bilan bog'liq neyronlar orqali uzatishi kerak – Bu juda katta CPU quvvati va vaqtini talab qiladi.

Shmidxuberning ta'kidlashicha, 21-asrda neyron tarmoqlarning qayta tiklanishi asosan apparat ta'minotidagi yutuqlar bilan bog'liq: 1991 yildan 2015 yilgacha hisoblash quvvati, ayniqsa GPGPUlar ( GPU'lar ) tomonidan etkazib berilganidek, taxminan bir million barobar oshdi. oldingidan bir necha qatlam chuqurroq bo'lgan o'qitish tarmoqlari uchun standart orqaga tarqalish algoritmi. [9] FPGA va GPU kabi tezlatgichlardan foydalanish mashg'ulotlar vaqtini bir necha oydan kungacha qisqartirishi mumkin. [141]

Neyromorfik muhandislik yoki jismoniy neyron tarmoq kontaktlarning zanglashiga olib keladigan neyron tarmoqlarini to'g'ridan-to'g'ri amalga oshirish uchun von-Neumann bo'lmagan chiplarni qurish orqali apparat qiyinchiliklarini to'g'ridan-to'g'ri hal qiladi. Neyron tarmoqlarni qayta ishlash uchun optimallashtirilgan yana bir chip turi Tensor Processing Unit yoki TPU deb ataladi. [142]

Amaliy qarama-qarshi misollar

ANN tomonidan o'rganilgan narsalarni tahlil qilish biologik neyron tarmoq tomonidan o'rganilgan narsalarni tahlil qilishdan ko'ra osonroqdir. Bundan tashqari, neyron tarmoqlar uchun o'rganish algoritmlarini o'rganish bilan shug'ullanadigan tadqiqotchilar asta-sekin o'quv mashinasining muvaffaqiyatli bo'lishiga imkon beruvchi umumiy tamoyillarni ochib berishadi. Misol uchun, mahalliy va mahalliy bo'lmagan o'rganish va sayoz va chuqur arxitektura. [143]

Gibrid yondashuvlar

Gibrid modellar tarafdorlari (neyron tarmoqlari va ramziy yondashuvlarni birlashtirgan holda) bunday aralash inson ongining mexanizmlarini yaxshiroq qamrab olishini da'vo qilmoqda. [144] [145]

Galereya

-

Bir qatlamli oldinga yo'naltirilgan sun'iy neyron tarmoq. dan kelib chiqadigan o'qlar aniqlik uchun olib tashlandi. Ushbu tarmoqqa p kirish va q chiqish mavjud. Bu sistemada q-chi chiqish qiymati, sifatida hisoblab chiqiladi

-

Ikki qatlamli oldinga yo'naltirilgan sun'iy neyron tarmoq.

-

Sun'iy neyron tarmog'i.

-

ANN bog'liqlik grafigi.

-

4 ta kirish, 6 ta yashirin va 2 ta chiqishga ega boʻlgan bir qatlamli oldinga yoʻnaltirilgan sunʼiy neyron tarmoq. Berilgan pozitsiya holati va yo'nalishi g'ildirak asosidagi boshqaruv qiymatlarini chiqaradi.

-

8 ta kirish, 2x8 yashirin va 2 ta chiqishga ega ikki qavatli oldinga uzatiladigan sun'iy neyron tarmoq. Berilgan joylashuv holati, yo'nalish va boshqa atrof-muhit qiymatlari itaruvchiga asoslangan boshqaruv qiymatlarini chiqaradi.

-

CMAC neyron tarmog'ining parallel quvur liniyasi tuzilishi. Ushbu o'rganish algoritmi bir bosqichda birlashishi mumkin.

Manbalar

Bibliografiya

- Bhadeshia H. K. D. H. (1999). "Neural Networks in Materials Science". ISIJ International 39 (10): 966–979. doi:10.2355/isijinternational.39.966. http://www.msm.cam.ac.uk/phase-trans/abstracts/neural.review.pdf.

- Bishop, Christopher M.. Neural networks for pattern recognition. Clarendon Press, 1995. ISBN 978-0-19-853849-3. OCLC 33101074.

- Borgelt, Christian. Neuro-Fuzzy-Systeme : von den Grundlagen künstlicher Neuronaler Netze zur Kopplung mit Fuzzy-Systemen. Vieweg, 2003. ISBN 978-3-528-25265-6. OCLC 76538146.

- Cybenko, G.V. „Approximation by Superpositions of a Sigmoidal function“,. Mathematics of Control, Signals, and Systems van Schuppen: . Springer International, 2006 — 303–314 bet. PDF

- Dewdney, A. K.. Yes, we have no neutrons : an eye-opening tour through the twists and turns of bad science. New York: Wiley, 1997. ISBN 978-0-471-10806-1. OCLC 35558945.

- Duda, Richard O.. Pattern classification, 2, Wiley, 2001. ISBN 978-0-471-05669-0. OCLC 41347061.

- Egmont-Petersen, M.; de Ridder, D.; Handels, H. (2002). "Image processing with neural networks – a review". Pattern Recognition 35 (10): 2279–2301. doi:10.1016/S0031-3203(01)00178-9.

- {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“.

- created for National Science Foundation, Contract Number EET-8716324, and Defense Advanced Research Projects Agency (DOD), ARPA Order No. 4976 under Contract F33615-87-C-1499.

- Gurney, Kevin. An introduction to neural networks. UCL Press, 1997. ISBN 978-1-85728-673-1. OCLC 37875698.

- Haykin, Simon S.. Neural networks : a comprehensive foundation. Prentice Hall, 1999. ISBN 978-0-13-273350-2. OCLC 38908586.

- Hertz, J.. Introduction to the theory of neural computation. Addison-Wesley, 1991. ISBN 978-0-201-51560-2. OCLC 21522159.

- Information theory, inference, and learning algorithms. Cambridge University Press, 25 September 2003. ISBN 978-0-521-64298-9. OCLC 52377690.

- Kruse, Rudolf. Computational intelligence : a methodological introduction. Springer, 2013. ISBN 978-1-4471-5012-1. OCLC 837524179.

- Lawrence, Jeanette. Introduction to neural networks : design, theory and applications. California Scientific Software, 1994. ISBN 978-1-883157-00-5. OCLC 32179420.

- MacKay, David, J.C.. Information Theory, Inference, and Learning Algorithms. Cambridge University Press, 2003. ISBN 978-0-521-64298-9.

- Masters, Timothy. Signal and image processing with neural networks : a C++ sourcebook. J. Wiley, 1994. ISBN 978-0-471-04963-0. OCLC 29877717.

- Ripley, Brian D.. Pattern Recognition and Neural Networks. Cambridge University Press, 2007. ISBN 978-0-521-71770-0.

- Siegelmann, H.T.; Sontag, Eduardo D. (1994). "Analog computation via neural networks". Theoretical Computer Science 131 (2): 331–360. doi:10.1016/0304-3975(94)90178-3.

- Smith, Murray. Neural networks for statistical modeling. Van Nostrand Reinhold, 1993. ISBN 978-0-442-01310-3. OCLC 27145760.

- Wasserman, Philip D.. Advanced methods in neural computing. Van Nostrand Reinhold, 1993. ISBN 978-0-442-00461-3. OCLC 27429729.

- Wilson, Halsey. Artificial intelligence. Grey House Publishing, 2018. ISBN 978-1-68217-867-6.

- ↑ McCulloch, Warren; Walter Pitts (1943). "A Logical Calculus of Ideas Immanent in Nervous Activity". Bulletin of Mathematical Biophysics 5 (4): 115–133. doi:10.1007/BF02478259.

- ↑ Hebb, Donald. The Organization of Behavior. New York: Wiley, 1949. ISBN 978-1-135-63190-1.

- ↑ Farley, B.G.; W.A. Clark (1954). "Simulation of Self-Organizing Systems by Digital Computer". IRE Transactions on Information Theory 4 (4): 76–84. doi:10.1109/TIT.1954.1057468.

- ↑ Haykin (2008) Neural Networks and Learning Machines, 3rd edition

- ↑ Rosenblatt, F. (1958). "The Perceptron: A Probabilistic Model For Information Storage And Organization in the Brain". Psychological Review 65 (6): 386–408. doi:10.1037/h0042519. PMID 13602029.

- ↑ Werbos, P.J.. Beyond Regression: New Tools for Prediction and Analysis in the Behavioral Sciences, 1975.

- ↑ Rosenblatt, Frank (1957). "The Perceptron—a perceiving and recognizing automaton". Report 85-460-1 (Cornell Aeronautical Laboratory).

- ↑ Olazaran, Mikel (1996). "A Sociological Study of the Official History of the Perceptrons Controversy". Social Studies of Science 26 (3): 611–659. doi:10.1177/030631296026003005.

- ↑ 9,0 9,1 9,2 Schmidhuber, J. (2015). "Deep Learning in Neural Networks: An Overview". Neural Networks 61: 85–117. doi:10.1016/j.neunet.2014.09.003. PMID 25462637. Manba xatosi: Invalid

<ref>tag; name "SCHIDHUB2" defined multiple times with different content - ↑ Ivakhnenko, A. G.. Cybernetic Predicting Devices. CCM Information Corporation, 1973.

- ↑ Ivakhnenko, A. G.. Cybernetics and forecasting techniques. American Elsevier Pub. Co., 1967.

- ↑ 12,0 12,1 12,2 Schmidhuber, Jürgen (2015). "Deep Learning". Scholarpedia 10 (11): 85–117. doi:10.4249/scholarpedia.32832. Manba xatosi: Invalid

<ref>tag; name "scholarpedia2" defined multiple times with different content - ↑ Dreyfus, Stuart E. (1 September 1990). "Artificial neural networks, back propagation, and the Kelley-Bryson gradient procedure". Journal of Guidance, Control, and Dynamics 13 (5): 926–928. doi:10.2514/3.25422. ISSN 0731-5090.

- ↑ Mizutani, E.; Dreyfus, S.E.; Nishio, K. (2000). "On derivation of MLP backpropagation from the Kelley-Bryson optimal-control gradient formula and its application". Proceedings of the IEEE-INNS-ENNS International Joint Conference on Neural Networks. IJCNN 2000. Neural Computing: New Challenges and Perspectives for the New Millennium (IEEE): 167–172 vol.2. doi:10.1109/ijcnn.2000.857892. ISBN 0-7695-0619-4.

- ↑ Kelley, Henry J. (1960). "Gradient theory of optimal flight paths". ARS Journal 30 (10): 947–954. doi:10.2514/8.5282.

- ↑ "Proceedings of the Harvard Univ. Symposium on digital computers and their applications". April 1961.

- ↑ Minsky, Marvin. Perceptrons: An Introduction to Computational Geometry. MIT Press, 1969. ISBN 978-0-262-63022-1.

- ↑ Linnainmaa, Seppo (1976). "Taylor expansion of the accumulated rounding error". BIT Numerical Mathematics 16 (2): 146–160. doi:10.1007/bf01931367.

- ↑ Dreyfus, Stuart (1973). "The computational solution of optimal control problems with time lag". IEEE Transactions on Automatic Control 18 (4): 383–385. doi:10.1109/tac.1973.1100330.

- ↑ Werbos, Paul „Applications of advances in nonlinear sensitivity analysis“,. System modeling and optimization. Springer, 1982 — 762–770 bet.

- ↑ Mead, Carver A.. Analog VLSI Implementation of Neural Systems, The Kluwer International Series in Engineering and Computer Science. Norwell, MA: Kluwer Academic Publishers, 8 May 1989. DOI:10.1007/978-1-4613-1639-8. ISBN 978-1-4613-1639-8.

- ↑ David E. Rumelhart, Geoffrey E. Hinton & Ronald J. Williams, "Learning representations by back-propagating errors ," Nature', 323, pages 533–536 1986.

- ↑ Qian, Ning, and Terrence J. Sejnowski. "Predicting the secondary structure of globular proteins using neural network models." Journal of molecular biology 202, no. 4 (1988): 865-884.

- ↑ Bohr, Henrik, Jakob Bohr, Søren Brunak, Rodney MJ Cotterill, Benny Lautrup, Leif Nørskov, Ole H. Olsen, and Steffen B. Petersen. "Protein secondary structure and homology by neural networks The α-helices in rhodopsin." FEBS letters 241, (1988): 223-228

- ↑ Rost, Burkhard, and Chris Sander. "Prediction of protein secondary structure at better than 70% accuracy." Journal of molecular biology 232, no. 2 (1993): 584-599.

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Cresceptron: a self-organizing neural network which grows adaptively," Proc. International Joint Conference on Neural Networks, Baltimore, Maryland, vol I, pp. 576–581, June 1992.

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation of 3-D objects from 2-D images," Proc. 4th International Conf. Computer Vision, Berlin, Germany, pp. 121–128, May 1993.

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation using the Cresceptron," International Journal of Computer Vision, vol. 25, no. 2, pp. 105–139, Nov. 1997.

- ↑ J. Schmidhuber., "Learning complex, extended sequences using the principle of history compression," Neural Computation, 4, pp. 234–242, 1992.

- ↑ Domingos, Pedro. The Master Algorithm: How the Quest for the Ultimate Learning Machine Will Remake Our World. chapter 4: Basic Books, September 22, 2015. ISBN 978-0465065707.

- ↑ Smolensky, P. „Information processing in dynamical systems: Foundations of harmony theory.“,. Parallel Distributed Processing: Explorations in the Microstructure of Cognition D. E. Rumelhart: , 1986 — 194–281 bet. ISBN 978-0-262-68053-0.

- ↑ Ng, Andrew; Dean, Jeff (2012). "Building High-level Features Using Large Scale Unsupervised Learning". arXiv:1112.6209 [cs.LG].

- ↑ Ian Goodfellow and Yoshua Bengio and Aaron Courville. Deep Learning. MIT Press, 2016.

- ↑ Cireşan, Dan Claudiu; Meier, Ueli; Gambardella, Luca Maria; Schmidhuber, Jürgen (21 September 2010). "Deep, Big, Simple Neural Nets for Handwritten Digit Recognition". Neural Computation 22 (12): 3207–3220. doi:10.1162/neco_a_00052. ISSN 0899-7667. PMID 20858131.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Graves, Alex; and Schmidhuber, Jürgen; Offline Handwriting Recognition with Multidimensional Recurrent Neural Networks, in Bengio, Yoshua; Schuurmans, Dale; Lafferty, John; Williams, Chris K. I.; and Culotta, Aron (eds.), Advances in Neural Information Processing Systems 22 (NIPS'22), 7–10 December 2009, Vancouver, BC, Neural Information Processing Systems (NIPS) Foundation, 2009, pp. 545–552.

- ↑ 37,0 37,1 Graves, A.; Liwicki, M.; Fernandez, S.; Bertolami, R.; Bunke, H.; Schmidhuber, J. (2009). "A Novel Connectionist System for Improved Unconstrained Handwriting Recognition". IEEE Transactions on Pattern Analysis and Machine Intelligence 31 (5): 855–868. doi:10.1109/tpami.2008.137. PMID 19299860. http://www.idsia.ch/~juergen/tpami_2008.pdf.

- ↑ 38,0 38,1 Graves, Alex; Schmidhuber, Jürgen (2009). Bengio, Yoshua. ed. "Offline Handwriting Recognition with Multidimensional Recurrent Neural Networks". Neural Information Processing Systems (NIPS) Foundation (Curran Associates, Inc) 21: 545–552. https://papers.nips.cc/paper/3449-offline-handwriting-recognition-with-multidimensional-recurrent-neural-networks.

- ↑ Graves, A.; Liwicki, M.; Fernández, S.; Bertolami, R.; Bunke, H.; Schmidhuber, J. (May 2009). "A Novel Connectionist System for Unconstrained Handwriting Recognition". IEEE Transactions on Pattern Analysis and Machine Intelligence 31 (5): 855–868. doi:10.1109/tpami.2008.137. ISSN 0162-8828. PMID 19299860.

- ↑ Ciresan, Dan. Multi-column deep neural networks for image classification, June 2012 — 3642–3649 bet. DOI:10.1109/cvpr.2012.6248110. ISBN 978-1-4673-1228-8.

- ↑ 41,0 41,1 Zell, Andreas „chapter 5.2“,. Simulation neuronaler Netze, 1st (de), Addison-Wesley, 2003. ISBN 978-3-89319-554-1. OCLC 249017987.

- ↑ Artificial intelligence, 3rd, Addison-Wesley Pub. Co, 1992. ISBN 0-201-53377-4.

- ↑ Abbod, Maysam F (2007). "Application of Artificial Intelligence to the Management of Urological Cancer". The Journal of Urology 178 (4): 1150–1156. doi:10.1016/j.juro.2007.05.122. PMID 17698099.

- ↑ DAWSON, CHRISTIAN W (1998). "An artificial neural network approach to rainfall-runoff modelling". Hydrological Sciences Journal 43 (1): 47–66. doi:10.1080/02626669809492102.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Ciresan, Dan; Ueli Meier; Jonathan Masci; Luca M. Gambardella; Jurgen Schmidhuber (2011). "Flexible, High Performance Convolutional Neural Networks for Image Classification". Proceedings of the Twenty-Second International Joint Conference on Artificial Intelligence-Volume Volume Two 2: 1237–1242. http://www.idsia.ch/~juergen/ijcai2011.pdf. Qaraldi: 17 November 2013.Sunʼiy neyron tarmoqlari]]

- ↑ Zell, Andreas. Simulation Neuronaler Netze, 1st (de), Addison-Wesley, 1994 — 73 bet. ISBN 3-89319-554-8.

- ↑ Miljanovic, Milos (February–March 2012). "Comparative analysis of Recurrent and Finite Impulse Response Neural Networks in Time Series Prediction". Indian Journal of Computer and Engineering 3 (1). http://www.ijcse.com/docs/INDJCSE12-03-01-028.pdf.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Kelleher, John D. „7-8“,. Fundamentals of machine learning for predictive data analytics : algorithms, worked examples, and case studies, Brian Mac Namee, Aoife D'Arcy, 2, Cambridge, Massachusetts, 2020. ISBN 978-0-262-36110-1. OCLC 1162184998.

- ↑ Wei, Jiakai (2019-04-26). "Forget the Learning Rate, Decay Loss". arXiv:1905.00094 [cs.LG].

- ↑ Li, Y.. The Improved Training Algorithm of Back Propagation Neural Network with Self-adaptive Learning Rate, 1 June 2009 — 73–76 bet. DOI:10.1109/CINC.2009.111. ISBN 978-0-7695-3645-3.

- ↑ Huang, Guang-Bin; Zhu, Qin-Yu; Siew, Chee-Kheong (2006). "Extreme learning machine: theory and applications". Neurocomputing 70 (1): 489–501. doi:10.1016/j.neucom.2005.12.126.

- ↑ Widrow, Bernard (2013). "The no-prop algorithm: A new learning algorithm for multilayer neural networks". Neural Networks 37: 182–188. doi:10.1016/j.neunet.2012.09.020. PMID 23140797.

- ↑ Ollivier, Yann; Charpiat, Guillaume (2015). "Training recurrent networks without backtracking". arXiv:1507.07680 [cs.NE].

- ↑ ESANN. 2009

- ↑ 57,0 57,1 Hinton, G. E. (2010). "A Practical Guide to Training Restricted Boltzmann Machines". Tech. Rep. UTML TR 2010-003. https://www.researchgate.net/publication/221166159. Manba xatosi: Invalid

<ref>tag; name "RBMTRAIN" defined multiple times with different content - ↑ Ojha, Varun Kumar; Abraham, Ajith; Snášel, Václav (1 April 2017). "Metaheuristic design of feedforward neural networks: A review of two decades of research". Engineering Applications of Artificial Intelligence 60: 97–116. doi:10.1016/j.engappai.2017.01.013.

- ↑ Dominic, S.; Das, R.; Whitley, D.; Anderson, C. (July 1991). "Genetic reinforcement learning for neural networks". IJCNN-91-Seattle International Joint Conference on Neural Networks. IJCNN-91-Seattle International Joint Conference on Neural Networks. Seattle, Washington, USA: IEEE. doi:10.1109/IJCNN.1991.155315. ISBN 0-7803-0164-1. https://archive.org/details/ijcnn91seattlein01ieee.

- ↑ Hoskins, J.C.; Himmelblau, D.M. (1992). "Process control via artificial neural networks and reinforcement learning". Computers & Chemical Engineering 16 (4): 241–251. doi:10.1016/0098-1354(92)80045-B.

- ↑ Bertsekas, D.P.. Neuro-dynamic programming. Athena Scientific, 1996 — 512 bet. ISBN 978-1-886529-10-6.

- ↑ Secomandi, Nicola (2000). "Comparing neuro-dynamic programming algorithms for the vehicle routing problem with stochastic demands". Computers & Operations Research 27 (11–12): 1201–1225. doi:10.1016/S0305-0548(99)00146-X.

- ↑ de Rigo, D.; Rizzoli, A. E.; Soncini-Sessa, R.; Weber, E.; Zenesi, P. (2001). "Neuro-dynamic programming for the efficient management of reservoir networks". Proceedings of MODSIM 2001, International Congress on Modelling and Simulation. MODSIM 2001, International Congress on Modelling and Simulation. Canberra, Australia: Modelling and Simulation Society of Australia and New Zealand. doi:10.5281/zenodo.7481. ISBN 0-86740-525-2.

- ↑ Damas, M.; Salmeron, M.; Diaz, A.; Ortega, J.; Prieto, A.; Olivares, G. (2000). "Genetic algorithms and neuro-dynamic programming: application to water supply networks". Proceedings of 2000 Congress on Evolutionary Computation. 2000 Congress on Evolutionary Computation. La Jolla, California, USA: IEEE. doi:10.1109/CEC.2000.870269. ISBN 0-7803-6375-2.

- ↑ Deng, Geng. Neuro-dynamic programming for fractionated radiotherapy planning, Springer Optimization and Its Applications, 2008 — 47–70 bet. DOI:10.1007/978-0-387-73299-2_3. ISBN 978-0-387-73298-5.

- ↑ Bozinovski, S. (1982). "A self-learning system using secondary reinforcement". In R. Trappl (ed.) Cybernetics and Systems Research: Proceedings of the Sixth European Meeting on Cybernetics and Systems Research. North Holland. pp. 397–402. ISBN 978-0-444-86488-8.

- ↑ Bozinovski, S. (2014) "Modeling mechanisms of cognition-emotion interaction in artificial neural networks, since 1981." Procedia Computer Science p. 255-263

- ↑ Bozinovski, Stevo; Bozinovska, Liljana (2001). "Self-learning agents: A connectionist theory of emotion based on crossbar value judgment". Cybernetics and Systems 32 (6): 637–667. doi:10.1080/01969720118145.

- ↑ {{Yangiliklar manbasi}} andozasidan foydalanishda

title=parametri belgilanishi kerak. - ↑ Turchetti, Claudio (2004), Stochastic Models of Neural Networks, Frontiers in artificial intelligence and applications: Knowledge-based intelligent engineering systems, 102-jild, IOS Press, ISBN 9781586033880

- ↑ de Rigo, D.; Castelletti, A.; Rizzoli, A. E.; Soncini-Sessa, R.; Weber, E. (January 2005). "A selective improvement technique for fastening Neuro-Dynamic Programming in Water Resources Network Management". in Pavel Zítek. Proceedings of the 16th IFAC World Congress – IFAC-PapersOnLine. 16. 16th IFAC World Congress. Prague, Czech Republic: IFAC. doi:10.3182/20050703-6-CZ-1902.02172. ISBN 978-3-902661-75-3. http://www.nt.ntnu.no/users/skoge/prost/proceedings/ifac2005/Papers/Paper4269.html. Qaraldi: 30 December 2011.

- ↑ Ferreira, C. „Designing Neural Networks Using Gene Expression Programming“,. Applied Soft Computing Technologies: The Challenge of Complexity A. Abraham: . Springer-Verlag, 2006 — 517–536 bet.

- ↑ Da, Y.; Xiurun, G. (July 2005). "An improved PSO-based ANN with simulated annealing technique". in T. Villmann. New Aspects in Neurocomputing: 11th European Symposium on Artificial Neural Networks. Elsevier. doi:10.1016/j.neucom.2004.07.002. Archived from the original on 25 April 2012. https://web.archive.org/web/20120425233611/http://www.dice.ucl.ac.be/esann/proceedings/electronicproceedings.htm. Qaraldi: 30 December 2011.

- ↑ Wu, J.; Chen, E. (May 2009). "A Novel Nonparametric Regression Ensemble for Rainfall Forecasting Using Particle Swarm Optimization Technique Coupled with Artificial Neural Network". in Wang, H.. 6th International Symposium on Neural Networks, ISNN 2009. Springer. doi:10.1007/978-3-642-01513-7_6. ISBN 978-3-642-01215-0. Archived from the original on 31 December 2014. https://web.archive.org/web/20141231221755/http://www2.mae.cuhk.edu.hk/~isnn2009/. Qaraldi: 1 January 2012.

- ↑ 75,0 75,1 Ting Qin, et al. "A learning algorithm of CMAC based on RLS." Neural Processing Letters 19.1 (2004): 49–61.

- ↑ Ting Qin, et al. "Continuous CMAC-QRLS and its systolic array." Neural Processing Letters 22.1 (2005): 1–16.

- ↑ LeCun et al., "Backpropagation Applied to Handwritten Zip Code Recognition," Neural Computation, 1, pp. 541–551, 1989.

- ↑ Yann LeCun (2016). Slides on Deep Learning Online

- ↑ Hochreiter, Sepp; Schmidhuber, Jürgen (1 November 1997). "Long Short-Term Memory". Neural Computation 9 (8): 1735–1780. doi:10.1162/neco.1997.9.8.1735. ISSN 0899-7667. PMID 9377276.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Li, Xiangang; Wu, Xihong (15 October 2014). "Constructing Long Short-Term Memory based Deep Recurrent Neural Networks for Large Vocabulary Speech Recognition". arXiv:1410.4281 [cs.CL].

- ↑ Fan, Y.; Qian, Y.; Xie, F.; Soong, F. K. (2014). "TTS synthesis with bidirectional LSTM based Recurrent Neural Networks". Proceedings of the Annual Conference of the International Speech Communication Association, Interspeech: 1964–1968. https://www.researchgate.net/publication/287741874. Qaraldi: 13 June 2017.Sunʼiy neyron tarmoqlari]]

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Fan, Bo; Wang, Lijuan; Soong, Frank K.; Xie, Lei (2015). "Photo-Real Talking Head with Deep Bidirectional LSTM". Proceedings of ICASSP. https://www.microsoft.com/en-us/research/wp-content/uploads/2015/04/icassp2015_fanbo_1009.pdf.

- ↑ Silver, David; Hubert, Thomas; Schrittwieser, Julian; Antonoglou, Ioannis; Lai, Matthew; Guez, Arthur; Lanctot, Marc; Sifre, Laurent et al. (5 December 2017). "Mastering Chess and Shogi by Self-Play with a General Reinforcement Learning Algorithm". arXiv:1712.01815 [cs.AI].

- ↑ Goodfellow, Ian; Pouget-Abadie, Jean; Mirza, Mehdi; Xu, Bing; Warde-Farley, David; Ozair, Sherjil; Courville, Aaron; Bengio, Yoshua (2014). "Generative Adversarial Networks". Proceedings of the International Conference on Neural Information Processing Systems (NIPS 2014). pp. 2672–2680. https://papers.nips.cc/paper/5423-generative-adversarial-nets.pdf.

- ↑ Zoph, Barret; Le, Quoc V. (4 November 2016). "Neural Architecture Search with Reinforcement Learning". arXiv:1611.01578 [cs.LG].

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Turek, Fred D. (March 2007). "Introduction to Neural Net Machine Vision". Vision Systems Design 12 (3). http://www.vision-systems.com/articles/print/volume-12/issue-3/features/introduction-to-neural-net-machine-vision.html. Qaraldi: 5 March 2013.Sunʼiy neyron tarmoqlari]]

- ↑ Zissis, Dimitrios (October 2015). "A cloud based architecture capable of perceiving and predicting multiple vessel behaviour". Applied Soft Computing 35: 652–661. doi:10.1016/j.asoc.2015.07.002. https://zenodo.org/record/848743.

- ↑ Roman M. Balabin; Ekaterina I. Lomakina (2009). "Neural network approach to quantum-chemistry data: Accurate prediction of density functional theory energies". J. Chem. Phys. 131 (7): 074104. doi:10.1063/1.3206326. PMID 19708729.

- ↑ Silver, David (2016). "Mastering the game of Go with deep neural networks and tree search". Nature 529 (7587): 484–9. doi:10.1038/nature16961. PMID 26819042. http://web.iitd.ac.in/~sumeet/Silver16.pdf.

- ↑ Sengupta, Nandini; Sahidullah, Md; Saha, Goutam (August 2016). "Lung sound classification using cepstral-based statistical features". Computers in Biology and Medicine 75 (1): 118–129. doi:10.1016/j.compbiomed.2016.05.013. PMID 27286184.

- ↑ Choy, Christopher B., et al. "3d-r2n2: A unified approach for single and multi-view 3d object reconstruction." European conference on computer vision. Springer, Cham, 2016.

- ↑ Gessler, Josef (August 2021). "Sensor for food analysis applying impedance spectroscopy and artificial neural networks". RiuNet UPV (1): 8–12. https://riunet.upv.es/handle/10251/174498.

- ↑ Maitra, D. S.; Bhattacharya, U.; Parui, S. K. (August 2015). "CNN based common approach to handwritten character recognition of multiple scripts". 2015 13th International Conference on Document Analysis and Recognition (ICDAR): 1021–1025. doi:10.1109/ICDAR.2015.7333916. ISBN 978-1-4799-1805-8. https://ieeexplore.ieee.org/document/7333916.

- ↑ French, Jordan (2016). "The time traveller's CAPM". Investment Analysts Journal 46 (2): 81–96. doi:10.1080/10293523.2016.1255469.

- ↑ Ganesan, N (2010). "Application of Neural Networks in Diagnosing Cancer Disease Using Demographic Data". International Journal of Computer Applications 1 (26): 81–97. doi:10.5120/476-783.

- ↑ Bottaci, Leonardo (1997). "Artificial Neural Networks Applied to Outcome Prediction for Colorectal Cancer Patients in Separate Institutions". Lancet (The Lancet) 350 (9076): 469–72. doi:10.1016/S0140-6736(96)11196-X. PMID 9274582. Archived from the original on 23 November 2018. https://web.archive.org/web/20181123170444/http://www.lcc.uma.es/~jja/recidiva/042.pdf. Qaraldi: 2 May 2012.Sunʼiy neyron tarmoqlari]]

- ↑ Alizadeh, Elaheh; Lyons, Samanthe M; Castle, Jordan M; Prasad, Ashok (2016). "Measuring systematic changes in invasive cancer cell shape using Zernike moments". Integrative Biology 8 (11): 1183–1193. doi:10.1039/C6IB00100A. PMID 27735002. http://pubs.rsc.org/en/Content/ArticleLanding/2016/IB/C6IB00100A.

- ↑ Lyons, Samanthe (2016). "Changes in cell shape are correlated with metastatic potential in murine". Biology Open 5 (3): 289–299. doi:10.1242/bio.013409. PMID 26873952. PMC 4810736. //www.pubmedcentral.nih.gov/articlerender.fcgi?tool=pmcentrez&artid=4810736.

- ↑ Nabian, Mohammad Amin; Meidani, Hadi (28 August 2017). "Deep Learning for Accelerated Reliability Analysis of Infrastructure Networks". Computer-Aided Civil and Infrastructure Engineering 33 (6): 443–458. doi:10.1111/mice.12359.

- ↑ Nabian, Mohammad Amin; Meidani, Hadi (2018). "Accelerating Stochastic Assessment of Post-Earthquake Transportation Network Connectivity via Machine-Learning-Based Surrogates". Transportation Research Board 97th Annual Meeting. https://trid.trb.org/view/1496617.

- ↑ Díaz, E.; Brotons, V.; Tomás, R. (September 2018). "Use of artificial neural networks to predict 3-D elastic settlement of foundations on soils with inclined bedrock". Soils and Foundations 58 (6): 1414–1422. doi:10.1016/j.sandf.2018.08.001. ISSN 0038-0806.

- ↑ Govindaraju, Rao S. (1 April 2000). "Artificial Neural Networks in Hydrology. I: Preliminary Concepts". Journal of Hydrologic Engineering 5 (2): 115–123. doi:10.1061/(ASCE)1084-0699(2000)5:2(115).

- ↑ Govindaraju, Rao S. (1 April 2000). "Artificial Neural Networks in Hydrology. II: Hydrologic Applications". Journal of Hydrologic Engineering 5 (2): 124–137. doi:10.1061/(ASCE)1084-0699(2000)5:2(124).

- ↑ Peres, D. J.; Iuppa, C.; Cavallaro, L.; Cancelliere, A.; Foti, E. (1 October 2015). "Significant wave height record extension by neural networks and reanalysis wind data". Ocean Modelling 94: 128–140. doi:10.1016/j.ocemod.2015.08.002.

- ↑ Dwarakish, G. S.; Rakshith, Shetty; Natesan, Usha (2013). "Review on Applications of Neural Network in Coastal Engineering". Artificial Intelligent Systems and Machine Learning 5 (7): 324–331. http://www.ciitresearch.org/dl/index.php/aiml/article/view/AIML072013007.

- ↑ Ermini, Leonardo; Catani, Filippo; Casagli, Nicola (1 March 2005). "Artificial Neural Networks applied to landslide susceptibility assessment". Geomorphology. Geomorphological hazard and human impact in mountain environments 66 (1): 327–343. doi:10.1016/j.geomorph.2004.09.025.

- ↑ Nix, R.; Zhang, J. (May 2017). "Classification of Android apps and malware using deep neural networks". 2017 International Joint Conference on Neural Networks (IJCNN): 1871–1878. doi:10.1109/IJCNN.2017.7966078. ISBN 978-1-5090-6182-2.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Homayoun, Sajad; Ahmadzadeh, Marzieh; Hashemi, Sattar; Dehghantanha, Ali; Khayami, Raouf (2018), Dehghantanha, Ali; Conti, Mauro; Dargahi, Tooska (muh.), „BoTShark: A Deep Learning Approach for Botnet Traffic Detection“, Cyber Threat Intelligence, Advances in Information Security, Springer International Publishing: 137–153, doi:10.1007/978-3-319-73951-9_7, ISBN 978-3-319-73951-9

- ↑ and (January 1994). "Credit card fraud detection with a neural-network". 1994 Proceedings of the Twenty-Seventh Hawaii International Conference on System Sciences 3: 621–630. doi:10.1109/HICSS.1994.323314. ISBN 978-0-8186-5090-1.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Nagy, Alexandra (28 June 2019). "Variational Quantum Monte Carlo Method with a Neural-Network Ansatz for Open Quantum Systems". Physical Review Letters 122 (25): 250501. doi:10.1103/PhysRevLett.122.250501. PMID 31347886.

- ↑ Yoshioka, Nobuyuki; Hamazaki, Ryusuke (28 June 2019). "Constructing neural stationary states for open quantum many-body systems". Physical Review B 99 (21): 214306. doi:10.1103/PhysRevB.99.214306.

- ↑ Hartmann, Michael J.; Carleo, Giuseppe (28 June 2019). "Neural-Network Approach to Dissipative Quantum Many-Body Dynamics". Physical Review Letters 122 (25): 250502. doi:10.1103/PhysRevLett.122.250502. PMID 31347862.

- ↑ Vicentini, Filippo; Biella, Alberto; Regnault, Nicolas; Ciuti, Cristiano (28 June 2019). "Variational Neural-Network Ansatz for Steady States in Open Quantum Systems". Physical Review Letters 122 (25): 250503. doi:10.1103/PhysRevLett.122.250503. PMID 31347877.

- ↑ Forrest MD (April 2015). "Simulation of alcohol action upon a detailed Purkinje neuron model and a simpler surrogate model that runs >400 times faster". BMC Neuroscience 16 (27): 27. doi:10.1186/s12868-015-0162-6. PMID 25928094. PMC 4417229. //www.pubmedcentral.nih.gov/articlerender.fcgi?tool=pmcentrez&artid=4417229.

- ↑ Siegelmann, H.T.; Sontag, E.D. (1991). "Turing computability with neural nets". Appl. Math. Lett. 4 (6): 77–80. doi:10.1016/0893-9659(91)90080-F. http://www.math.rutgers.edu/~sontag/FTPDIR/aml-turing.pdf.

- ↑ Balcázar, José (Jul 1997). "Computational Power of Neural Networks: A Kolmogorov Complexity Characterization". IEEE Transactions on Information Theory 43 (4): 1175–1183. doi:10.1109/18.605580.

- ↑ 124,0 124,1 MacKay, David, J.C.. Information Theory, Inference, and Learning Algorithms. Cambridge University Press, 2003. ISBN 978-0-521-64298-9.

- ↑ Cover, Thomas (1965). "Geometrical and Statistical Properties of Systems of Linear Inequalities with Applications in Pattern Recognition". IEEE Transactions on Electronic Computers (IEEE) EC-14 (3): 326–334. doi:10.1109/PGEC.1965.264137. http://www-isl.stanford.edu/people/cover/papers/paper2.pdf.

- ↑ Gerald, Friedland (2019). "Reproducibility and Experimental Design for Machine Learning on Audio and Multimedia Data". MM '19: Proceedings of the 27th ACM International Conference on Multimedia (ACM): 2709–2710. doi:10.1145/3343031.3350545. ISBN 978-1-4503-6889-6.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Lee, Jaehoon; Xiao, Lechao; Schoenholz, Samuel S.; Bahri, Yasaman; Novak, Roman; Sohl-Dickstein, Jascha; Pennington, Jeffrey (2020). "Wide neural networks of any depth evolve as linear models under gradient descent". Journal of Statistical Mechanics: Theory and Experiment 2020 (12): 124002. doi:10.1088/1742-5468/abc62b.

- ↑ [1], Neural Tangent Kernel: Convergence and Generalization in Neural Networks.

- ↑ [2], Training Behavior of Deep Neural Network in Frequency Domain.

- ↑ [3], On the Spectral Bias of Neural Networks.

- ↑ [4], Frequency Principle: Fourier Analysis Sheds Light on Deep Neural Networks.

- ↑ [5], Theory of the Frequency Principle for General Deep Neural Networks.

- ↑ Xu, Zhiqin John; Zhou, Hanxu (2021-05-18). "Deep Frequency Principle Towards Understanding Why Deeper Learning Is Faster" (en). Proceedings of the AAAI Conference on Artificial Intelligence 35 (12): 10541–10550. ISSN 2374-3468. https://ojs.aaai.org/index.php/AAAI/article/view/17261.

- ↑ Crick, Francis (1989). "The recent excitement about neural networks". Nature 337 (6203): 129–132. doi:10.1038/337129a0. PMID 2911347.

- ↑ Adrian, Edward D. (1926). "The impulses produced by sensory nerve endings". The Journal of Physiology 61 (1): 49–72. doi:10.1113/jphysiol.1926.sp002273. PMID 16993776. PMC 1514809. //www.pubmedcentral.nih.gov/articlerender.fcgi?tool=pmcentrez&artid=1514809.

- ↑ Dewdney, A. K.. Yes, we have no neutrons: an eye-opening tour through the twists and turns of bad science. Wiley, 1 April 1997 — 82 bet. ISBN 978-0-471-10806-1.

- ↑ NASA – Dryden Flight Research Center – News Room: News Releases: NASA NEURAL NETWORK PROJECT PASSES MILESTONE. Nasa.gov. Retrieved on 20 November 2013.

- ↑ D. J. Felleman and D. C. Van Essen, "Distributed hierarchical processing in the primate cerebral cortex," Cerebral Cortex, 1, pp. 1–47, 1991.

- ↑ J. Weng, "Natural and Artificial Intelligence: Introduction to Computational Brain-Mind," BMI Press, ISBN 978-0-9858757-2-5, 2012.

- ↑ 141,0 141,1 Edwards, Chris (25 June 2015). "Growing pains for deep learning". Communications of the ACM 58 (7): 14–16. doi:10.1145/2771283.

- ↑ „Google Built Its Very Own Chips to Power Its AI Bots“. Wired.

- ↑ {{Veb manbasi}} andozasidan foydalanishda

sarlavha=parametrini belgilashingiz kerak. „{{{title}}}“. - ↑ Sun and Bookman (1990)

- ↑ Tahmasebi; Hezarkhani (2012). "A hybrid neural networks-fuzzy logic-genetic algorithm for grade estimation". Computers & Geosciences 42: 18–27. doi:10.1016/j.cageo.2012.02.004. PMID 25540468. PMC 4268588. //www.pubmedcentral.nih.gov/articlerender.fcgi?tool=pmcentrez&artid=4268588.

Manba xatosi: <ref> tags exist for a group named "lower-alpha", but no corresponding <references group="lower-alpha"/> tag was found

![{\displaystyle \textstyle C=E[(x-f(x))^{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2929ecb1606fdfeaddc55477d9671e11c034e21c)